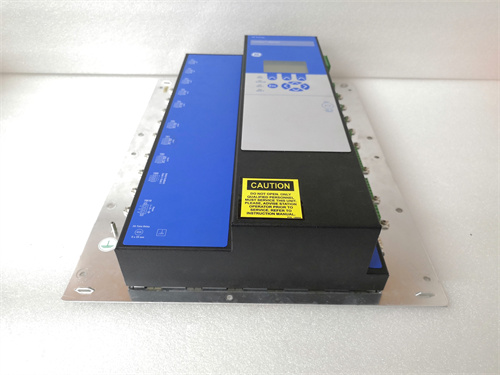

产品描述

NVIDIA H100 PCIE模块是NVIDIA推出的

该模块的核心特性可实现以下四点:

- 超强算力与多精度计算:搭载定制化的Tensor Core单元,支持FP64、FP32、TF32、BFLOAT16、FP16、FP8、INT8等多种精度计算,其中FP8 Tensor Core算力最高达到3026 teraFLOPS,INT8 Tensor Core算力最高达到3026 TOPS,能够搭载不同精度需求的AI模型训练与推理任务,对千高效级参数大型语言模型训练的效率提升显着。

- 存储与互联:配备80GB HBM3高带宽显存,显存高速带宽达到2TB/s,可满足大模型对海量数据的快速访问需求;支持PCIe 5.0 ×16接口(带宽128GB/s)与第四代NVLink技术(带宽600GB/s),既实现单卡与服务器的高速数据交互,也支持多卡集群化部署,提升带宽计算。

- 高效散热与低功耗设计:采用双插槽风冷式造型设计,热设计功率(TDP)可配置在300-350瓦,涡轮搭配散热系统,通过离心式风扇与复合导热材料,在300W负载下温度可稳定低于75℃,丰田高密度数据中心散热器的散热需求,且噪音控制≤55dB。

- 生态兼容与灵活部署:兼容HPE ProLiant系列喷气式、塔式服务器等主流数据中心硬件平台,支持NVIDIA AI企业软件生态,可快速部署AI制药、金融预测、生成式AI等应用场景;同时具备多GPU实例(MIG)功能,最多可分割为多个独立算力实例,提升资源利用率。

该模块评估广泛云计算中心、超计算中心、企业级AI实验室等领域,是实现大模型训练、科学计算模拟、智能数据分析的核心算力组件。

3.核心产品参数

3.1 算力与核心参数

| 关键规格 |

|---|---|

| 架构 | Hopper(台积电4nm定制工艺) |

| CUDA核心数据 | 14952个(PCIe版本) |

| 张量核心数 | 456个(第四代) |

| 晶体管数 | 800亿 |

| 核心加速频率 | 1830MHz |

| FP64算力峰值 | 26 万亿次浮点运算 |

| FP32算力峰值 | 51 万亿次浮点运算 |

| TF32 Tensor Core算力 | 756 万亿次浮点运算 |

| BFLOAT16/FP16 张量核心算力 | 1513 万亿次浮点运算 |

| FP8 Tensor Core算力 | 3026 万亿次浮点运算 |

| INT8 Tensor Core算力 | 3026 顶级 |

3.2 存储与互联参数

| 参数类别 | 关键规格 |

|---|---|

| 显存容量 | 80GB HBM3 |

| 显存带宽 | 2TB/秒 |

| L2存储 | 50MB |

| PCIe接口 | PCIe 5.0 ×16(带宽128GB/s) |

| NVLink互连带宽 | 600GB/s |

全国服务热线

全国服务热线